D'accord .Merci.De mon coté ,j amenerai une imprimante de plusieurs années mais encore fonctionnelle.Vers quelle heure y serez vous ?

-

Bonjours a Toutes et a tous ,

J'ai monter un dits server centos 8 stream .

Je lui est mis au niveau hardware :

cpu ryzen 5 3600

ram 32 Go

mobo b550

1 nvme 120 go ( / , /swap , /boot/efi )

1 grappe de 4 hdd 3 To ( /home )

reste a dispo deux ssd de 120 go samsung , pour mettre en place le dit ssdcache .Le but étant de mettre en place un lancache ( https://lancache.net/ ) , n'aillant pas pour l'instant la primeur d'avoir la fibre chez moi . ( vdsl 2 qui download a 3.2 mo /s max )

De base , j'arrive a tous mettre en place sans soucis , le dit lancache fonctionne , mais après divers download de ma dits bibliothèque ( steam , uplay , origin , etc ) , les débit tombe de plus en plus ....

Les premières download me fait un debit de 115 mo env ( ce qui est correcte pour un réseau local a 1 Gb/.s )

Pour tester si le lancache est bien en place , mais après x download , ça fini vers les 40 - 50 mo ...C'est pour ça que j'aimerais mettre en place un dit ssdcache , j'ai trouver un lien ( attention site a risque

) "https://rucore.net/en/configure-lvm-cache-ssd-caching-in-centos/"

) "https://rucore.net/en/configure-lvm-cache-ssd-caching-in-centos/"Je suis parti sur un installe comme dits juste en haut , mais le /home , je l'ai pas monter en lvm2 , pour me rapprocher au plus de la situation citer dans le "tutorial" .

ce qui donne en gros ceci :

fdisk -l

yum install lvm2 -y

umount /home- md126 est le nom de lecteur donner a /home

pvcreate /dev/md126 - md127 est le nom du lecteur ssd

pvcreate /dev/md127

vgcreate ssdcache /dev/md126 /dev/md127

lvcreate -l 100%FREE -n hdd_data ssdcache /dev/md126

lvcreate -L 16G -n ssd_meta ssdcache /dev/md127

lvcreate -l 90%FREE -n ssd_data ssdcache /dev/md127

lvconvert --type cache-pool --poolmetadata ssdcache/ssd_meta ssdcache/ssd_data

lvconvert --type cache --cachemode writeback --cachepool ssdcache/ssd_data ssdcache/hdd_data

lvs -a

mkfs.ext4 /dev/ssdcache/hdd_data

/dev/mapper/ssdcache-hdd_data :

UUID="" TYPE="ext4"

nano /etc/fstab

df -h

lvs -o+cache_mode ssdcacheTous ce passe bien , je remonte le /home , et part acquis de conscience je reboot le server pour mettre en place le reste ( installer lancache ) et là le "server" reste bloquer - qui fini sur une erreur " proposition de passer en mode rescue en gros ....

ça va loin quand même car je n'ai même plus accès au bios , la seul façon que j'ai trouver pour m'en sortir c'est de kill toutes les partions ...Donc voila mes déboires , et encore milles excuses pour se long monologues , mais je pense que c'est important .

Merci a l'avance pour les divers aides que vous pourriez m'apporte

P.S : je mets ceci en place parce que mon pc dits de jeu , qui d'ailleurs a fonctionner sous fedora 32 pendant un moment , mais qui a du retourner sous Windows car j'aime pas trop mettre une version beta de proton pour faire marcher MON jeu "Elite Dangerous " . Je lui est mis uniquement que 1 to pour mes data , et je pense pas mettre plus .

Préfère jongler avec le lancache si mes amis veulent jouer a un autre jeu pour éviter la lassitude .

.

Et aussi , si je dois refaire les pc d'un ami , enfants et pas passer 3 - 4 jours a re download sa bibliothèque

Cordialement a toutes et a tous .

Shini - md126 est le nom de lecteur donner a /home

-

Désoler , je rajoute un petit complément de la situation .

Le projet est monté sous Docker , car je n'aime pas podman .

Personnellement jugeant que sur le dit "server" , il n'y a aucun données personnelles , le fait de mettre Podman au lieu de Docker ne se justifie pas .

Donc pour être aussi au plus près du tutoriel de Lancache , je fais sauter podman et désactive tous ce qui peut me brider pour la réalisation de ceci .

Encore excusez moi pour se long monologue .

Cordialement .

Shini

-

Peut etre un probléme UUID dans ton /etc/fstab .

-

Bonjour,

Je n'ai (presque) RIEN compris !

Cordialement,

OlivierPS: Quel est le tuto lancache dont tu parles ?

-

@e1415

Bonjour ,

J'avais modifier justement UUID .

Je vais retenter , avec un peu de hantise pour etre franc . -

@olivier

C'est plus le tuto sur le ssdcache , du site russe qui me pose problème ( hormis que c'est un site un peu chaud )

)

La partie Lancache me pose pas trop de soucis , surtout depuis qu'ils ont automatiser la procédure . ( un voir deux fichiers max a paramétrer , c’était autre chose , il y a quelques mois de ça )

C'est surtout que plus je fais mes "save" sur le server de mes fichiers install de ma bibliothèque et plus mon débit tombe .

C'est pour ça que le ssdcache devient plus ou moins intelligent de le mettre en place ...

-

@shini a dit dans Je cherche comment mettre en place un ssdcache sous centos 8 stream :

@olivier

C'est plus le tuto sur le ssdcache , du site russe qui me pose problèmeLe tuto est une série de commandes LVM. Problématiques ?

Que vient faire docker dans l'histoire ?

-

@olivier

Je pense que vous connaissez pas Lancache , ce qui est normal d'un sens

Je vais vous mettre un lien direct de Lancache , vous allez comprendre direct

https://lancache.net/docs/Cordialement .

Shini -

@shini a dit dans Je cherche comment mettre en place un ssdcache sous centos 8 stream :

ssdcache

Tu est en RAID ?

-

Je pense que oui à cause des périphériques /dev/md126 (la grappe de 4 HDD ?) et /dev/md127 (les 2 SSD ?) qu'il cite.

-

@shini

Est écrit dans la doc :This project is heavily reliant on the hardware that you run it on. The most common complaint is “The cache is slow” and in nearly every case this can be attributed to the hardware that the cache is being run on.

Ce dont tu à l'air de te plaindre.

La doc propose cette configuration proche de la tienne :

Low capacity

“We have 20 ppl and somewhere to put them we need a name for our LAN. Also known as my housemates all game, lets level up.”

8 CPU core 16GB DDR3 2TB HDD + 512GB SSD LVM Cache. Without the LVM Cache the system will push around 300-400Mbps, with the SSD Cache pushing around 800-900MbpsIl est nullement fait allusion à des disques montés en RAID. Le RAID logiciel est lent et appartient au passé. Le tuto (dit brûlant) pour mettre en place un cache LVM sur SSD n'est peut-être pas adapté à ton cas. En effet tu peux mettre en place différent type de cache avec LVM. As-tu identifié celui du tuto ? Correspond il le mieux à la situation ?

Le mieux ne serait-il pas de se référer au

man lvmcache? RTFMLVMCACHE(7) LVMCACHE(7) NAME lvmcache — LVM caching DESCRIPTION lvm(8) includes two kinds of caching that can be used to improve the performance of a Log‐ ical Volume (LV). Typically, a smaller, faster device is used to improve i/o performance of a larger, slower LV. To do this, a separate LV is created from the faster device, and then the original LV is converted to start using the fast LV. The two kinds of caching are: • A read and write hot-spot cache, using the dm-cache kernel module. This cache is slow moving, and adjusts the cache content over time so that the most used parts of the LV are kept on the faster device. Both reads and writes use the cache. LVM refers to this using the LV type cache. • A streaming write cache, using the dm-writecache kernel module. This cache is intended to be used with SSD or PMEM devices to speed up all writes to an LV. Reads do not use this cache. LVM refers to this using the LV type writecache.Si le tuto du cache LVM fonctionne bien, que l'installation de lancache aussi (docker-compose) alors comment peut-on t'aider ? Des captures des résultats de commandes telles que

fdisk -l,lvs -a, etc. seraient un plus pour aider au dépannage

-

@olivier a dit dans Je cherche comment mettre en place un ssdcache sous centos 8 stream :

man lvmcache

Justement c'est la mise en place du lvmcache qui se passe pas correctement , un perte total d'accès du dit "server" .

La je suis repartie de 0 , car je n'avais plus accès a mon pc .

Aussi bien en pressent F11 pour choisir mon périphérique de boot , que accès au bios .

ça là que je me dit " punaise , ça va loin ce bug "

J'ai du attendre d'avoir le mode "rescue" pour taper un fdisk /dev/sd(x)

Et kill toutes mes partitions avec la variable : d .Justement , hier soir . J'arrivais pas a dormir , car j'aimerais que ceci soit de l'ordre du passer ( Et oui je suis comme ça

)

)

Donc j'ai fais diverses recherches sur la toile .

J'ai cherché lvmcache vs dm-cache , car j'ai toujours en tête d'optimiser mes I/O .

J'ai vu que les gains ne sont pas toujours là , il en ai ressorti une autre méthode de cache ( bcache ) .

Qui apparemment est un peut plus ardu a mettre en place , mais qui colle franchement a mon type d'utilisation .https://www.linux-geex.com/benchmark-bcache-vs-lvmcache-vs-no-cache/

Je suis en train de me demander , si je dois pas partir avec un seul HDD pour /home et ensuite de créer ma grappe avec les 3 autres HDD ( via fdisk ) --- J'oublie gparted car si j'ai bien compris il lui faut un interface graphique ce coquin

Le raid 0 des ssd m'ont plus ou moins imposer part le lvmcache , car avec un seul quand j'ai taper :

"lvconvert --type cache-pool --poolmetadata ssdcache/ssd_meta ssdcache/ssd_data" , il m'a fait comprendre qu'au niveau des block ça passé pas .

Et ceci disparait quand j'ai monté un raid de mes deux ssd .En tout cas merci de l’intérêt que vous me portez , j'en suis même surpris pour être franc .

Je vais relancé la bête et faire le maximum de screenshoot .

Merci .

Cordialement .

Shini -

Bonjour a Toutes et a Tous ,

Je crois que je vais prendre une autre direction dans mon projet .

J'ai toujours l'intention de monter mon lancache , mais comme j'ai du refaire mon NAS ces derniers jours , j'ai eu une idée qui a popper dans ma tête ....

Pourquoi ne pas monter ceci sur une zfs ?

En plus je pourrais dédier mes deux ssd en cache .....Donc je voudrais savoir , si ma logique est bonne ....

Au lieu de faire un lvm de mes 4x 2,7 To a l'installation , je fais une installation traditionnel ...

comme ceci :

sur mon nvme :

/

/boot/efi

/swap

....

C'est que je pense monter QUE sur un hdd , le /home ( surement le /dev/sda )Et après monter mon zpool en raidz ; comme ceci :

- zpool create raidz /dev/sda /dev/sdb /dev/sdc /dev/sdd cache /dev/sde /dev/sdf

- rappel :

sda 2.7 to hdd

sdb 2.7 to hdd

sdc 2.7 to hdd

sdd 2.7 to hddsde 120 go ssd

sdf 120 go ssdPour vous , c'est bon ou pas la logique ?

Merci a l'avance pour vos réponses .

Cordialerment .

Shini

- sources :

https://blog.eldernode.com/install-zfs-file-on-centos-8/https://www.symmcom.com/docs/how-tos/storages/how-to-install-zfs-on-centos-7

-

ZFS très présent sur les systèmes BSD et depuis quelques temps sur Linux n'offre ici à mon avis aucun intérêt. Pourquoi alors ne pas choisir Btrfs, un autre système de fichier, similaire à ZFS. Les ressources matérielles demandées par lancache sont importantes et ZFS est gourmand lui aussi.

L'appli lancache est distribuée sous la forme d'un conteneur. Sous docker il existe des volumes. Comment ça se passe avec lancache ? Y a-t-il des variables à configurer ?

-

@olivier , Bonsoir .

Tu n'as pas beaucoup de variable a régler dans Lancache .

Tu as un .yml a des commenter et changer la variable part "always" pour que tes containers se relance a chaque reboot . ( s'il y a lieu d’être )

Déclarer tes IPs pour une sorte de @alias pour que chaques services ( steam , origin , uplay , epic , windop update .... ) est une IP .....

Ton dns .....Le poids max de ton dossier "save" , de base in est régler sur 1 To , d'ailleurs la premiers fois , je me suis fait avoir .... Un fois arriver a la capacité max , monsieur ne me l'a pas dit , il a supprimer les plus anciens .....

Après je vais te dire , ce pc/server ne sera dédier qu'a ça , pas de containers plex , ou autres dessus .

Même si je dois dans quelques mois doubler la ram , ça me couteras toujours moins cher que migres TOUS mes HDD en SDD , car 4 x 4 To en ssd voir 6x tant qu'a faire ceci , ça commence a faire très mal

Après mon NAS Diy ( TrueNAS ) sur base am1 2c/4th avec seulement 8 Go , 1 ssd pour l'os et 2 HDD en "raid " , je trouve qu'il envoi grave .

Je descend rarement sous les 95 Mo/s avec des pointes a 115 Mo/s .J'ai regarder btrfs , euh comment dire , le principe est pas mal , mais plus accès H.A , ce que j'ai pu lire c'est qu'il bouffe pas mal en ressources stockage ....

Déjà que Raidz ne fait un disque de parité , je me retrouve a un peu plus de 8 To sur les 12.7 To , je vais me trouver a combien après ?

Je pourrais toujours mettre Docker sur le pc sur une couche TrueNas comme ceci , mais ça serait manger des ressources d'un sens ....

https://www.youtube.com/watch?v=XBVjuwgz0Cg

Mais a mes yeux , c'est comme faire de la vm Gaming sous Unraid

J'aime le challenge quand même

Cordialement.

Shini -

@olivier Après ce que j'ai pu lire , c'est que ça risque d’être l’héritier du ext4 ....

ça va couter cher cette histoire ....ZFS

Présentation et historiqueZFS a été développé dans l’objectif d’être le système de fichier “ultime”. Le projet a été lancé par Sun Microsystem entreprise maintenant rachetée par Oracle. Il a fait sa première apparition en 2005 sur Solaris et a été totalement intégré mi 2006.

Il intègre en un seul produit le système de fichiers et la gestion de volumes.

Points forts- vérification de disque à chaud - vérification des métadata et des data lors d’une vérification de disque - systeme de snapshot très performant par différence - possibilité de transférer des snapshot par le réseau, via ssh - possibilité de définir un device pour faire du cache sur un pool de disque raidz (aucune, simple, double, ou triple partité)Points faibles

pas intégrable directement dans le noyau linux à cause de sa license

Btrfs

Présentation et historiqueLe projet de B-tree File System (Btrfs, à prononcer Butter-FS) voit le jour fin 2007 et a pour but de créer un système de fichier combinant toutes les couches habituellement utilisées (mdadm/lvm/fs…) en un produit unique. Ainsi, puisqu’il en a connaissances, Btrfs est capable de faire plus de choses et de les faire plus rapidement qu’un système de fichier utilisant des couches indépendantes (et universelles).

Son rôle sur le long terme est de remplacer ext4. Cependant, tant que son développement n’est pas terminé, il souffre de beaucoup de points faibles et la plupart de ses fonctionnalité se retrouvent déjà dans les produits actuels.

Points forts- Garantir la fiabilité des données - Réaliser des instantanés au niveau fichier - Mode « 3 copies » : RAID1 sur 3 blocs au lieu de 2 - Le « scrubbing » automatique en tâche de fond pour régulièrement traquer les corruptions et ventiler uniformément les données entre les disques - De nouveaux algorithmes de compression, plus rapide (Snappy, de chez Google, ou LZ4, en plus de zlib et LZO)Points faibles

- Plus de 50% du disque sera utilisé pour assurer cette sécurité

- Pas de chiffrement des données

- En cas de panne d’un disque, il est nécéssaire de démonter le FS !

- Une fragmentation importante.

- Une fiabilité encore très éloignées des FS habituels.Pour une entreprise qui a les reins solide pourquoi pas , ou encore un Streamer qui a un accord commercial avec samsung part exemple .....

Mais en tous cas merci pour ta réponse

Cordialement .

Shini

Source : https://vonkrafft.fr/dossiers/systeme-de-fichier-zsf-btrfs-ou-ext4/

P.S : Après je garde de coter ton idée , surtout quand tu vois ceci

https://vonkrafft.fr/dossiers/systeme-de-fichier-emergence-btrfs/ -

Bonjour a Toutes et a Tous ,

Après mettre essayé a ZFS , j'ai laissé tomber pour l'instant ( je dis bien pour l'instant )

J'ai testé aussi bien sur Centos 8 stream , Ubuntu 20.04 , Oracle Linux ...

C'est pas grave , j'y reviendrai un jours

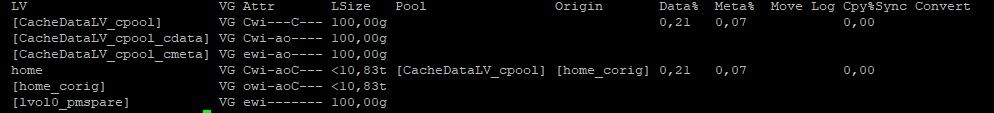

Donc je suis reparti sur le Lvm-cache , et là après x recherche et aussi un peu plus de recul , j'ai enfin réussi ...

Preuve a l'appuie

Donc merci de votre aide que vous avez bien voulu me partager .

Cordialement .

Shini

C'est juste le LV Lent ( HDD ) qui n'est pas susnommé comme sur l'article , mais ça marche